- Was bedeutet Genauigkeit bei Digitalmultimetern?

- Wie liefern Digitalmultimeter konsistente Messergebnisse?

- Was bedeutet Auflösung bei Messungen?

- Welche Messbereiche hat ein Multimeter?

- Was ist der Unterschied zwischen Anzeigeumfang und Stellen?

Die Verwendung eines Multimeters, das die richtigen Messergebnisse liefert, ist wichtig. Noch wichtiger ist es, diese Messergebnisse richtig einordnen zu können. Genauigkeit und Präzision sorgen dafür, dass die von Ihnen durchgeführten Messungen einen hohen Nutzen für Ihre Arbeit haben. Höhere Präzision ermöglicht eine bessere Wiederholbarkeit, und höhere Genauigkeit bedeutet, dass Ihre Messwerte näher am Idealwert sind.

Was bedeutet Genauigkeit bei Digitalmultimetern?

Genauigkeit ist die größte zulässige Abweichung, die laut der Spezifikationen unter spezifischen Betriebsbedingungen auftreten darf. Unsicherheit wäre gemäß metrologischer Normen der bessere Begriff, meistens wird jedoch Genauigkeit (in der englischen Literatur „Accuracy“) verwendet. Sie wird in Prozent ausgedrückt und gibt an, wie weit das angezeigte Messergebnis vom tatsächlichen Wert des zu messenden Signals abweicht. Genauigkeit erfordert einen Vergleich mit anerkannten Normalen (z. B. mit Kalibratoren). Der Fachbegriff ist rückführbare Kalibrierung.

Die Genauigkeit eines bestimmten Digitalmultimeters ist je nach Anwendung wichtig. An Wechselstromleitungen kann die Spannung beispielsweise um ±5 % oder mehr variieren. Ein Beispiel für diese Schwankung ist eine Spannungsmessung an einer Steckdose mit 230 V Wechselstrom. Wenn mit dem Digitalmultimeter nur geprüft werden soll, ob die Steckdose aktiv ist, ist eine Genauigkeit von ±3 % bei der Messung durchaus in Ordnung.

Bei einigen Anwendungen, beispielsweise bei der Kalibrierung von Geräten in den Bereichen Automobiltechnik, Medizin, Luft- und Raumfahrt oder bei speziellen Industrieanlagen, ist oft eine höhere Genauigkeit erforderlich. Ein Wert von 100,0 V kann also auf einem Digitalmultimeter mit einer (Grund-)Genauigkeit von ±2 % tatsächlich zwischen 98,0 V und 102,0 V angezeigt werden. Das kann für einige Anwendungen in Ordnung sein, ist aber nicht akzeptabel für empfindliche elektronische Geräte.

Bei der Genauigkeit muss außerdem noch berücksichtigt werden, wie viele Zählwerte , die die Anzahl der Schritte der letzten angezeigten Stelle bezeichnen (in Englisch "LSD"= Least significant Digits), zur Spezifikation der Grundgenauigkeit hinzukommen. Eine Genauigkeit von ±(2 % + 2 Zählwerte) bedeutet, dass ein Wert von 100,0 V auf dem Multimeter zwischen 97,8 V und 102,2 V angezeigt werden kann. Die Verwendung eines Digitalmultimeters mit höherer Genauigkeit ergibt deutlich mehr Anwendungsmöglichkeiten.

Die Grundgenauigkeit bei Gleichspannung beträgt bei den tragbaren Digitalmultimetern von Fluke 0,5 % bis 0,025 %.

Wie präzise ist dieses Digitalmultimeter?

Präzision bezieht sich auf die Fähigkeit eines Digitalmultimeters, bei wiederholten Messungen das gleiche Ergebnis zu erzielen.

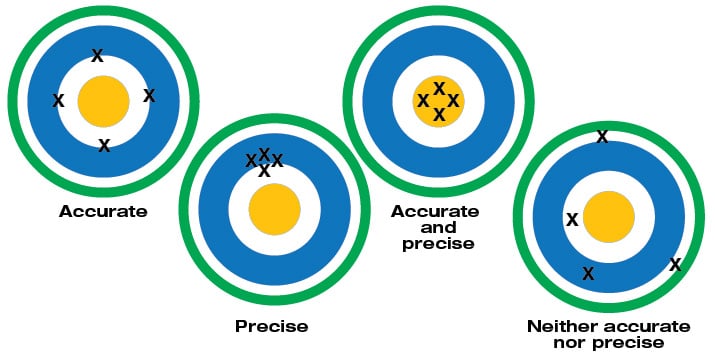

Ein häufig verwendetes Beispiel zur Erläuterung der Präzision ist die Anordnung der Treffer auf dem Ziel eines Schießstands. Bei diesem Beispiel wird davon ausgegangen, dass ein Gewehr genau auf die Mitte des Ziels gerichtet und jedes Mal von derselben Position aus geschossen wird.

Sind die Treffer nahe beieinander, aber nicht auf der Mitte, kann das Gewehr (oder der Schütze) als präzise, aber nicht genau betrachtet werden.

Sind die Treffer dicht an dicht in der Mitte, ist das Gewehr genau und präzise. Wenn die Treffer wahllos über das gesamte Ziel verteilt sind, ist es weder genau noch präzise (oder wiederholbar).

Unter bestimmten Umständen ist Präzision bzw. Wiederholbarkeit wichtiger als Genauigkeit. Wenn die Messungen wiederholbar sind, ist es zudem möglich, ein Fehlermuster zu ermitteln und es zu kompensieren.

Was bedeutet Auflösung bei Messungen?

Die Auflösung ist der kleinste Schritt, den ein Messgerät erfassen und anzeigen kann.

Betrachten wir als nicht elektrisches Beispiel zwei Lineale. Ein Lineal mit einer Millimeter-Einteilung bietet eine höhere Auflösung als ein Lineal mit einer Fünf-Millimeter-Einteilung.

Nehmen wir nun eine einfache Prüfung einer 1,5-V-Haushaltsbatterie als Beispiel. Wenn ein Digitalmultimeter eine Auflösung von 1 mV im 3-V-Bereich hat, kann beim Messen der Spannung eine Änderung von 1 mV festgestellt werden. Der Anwender kann Änderungen von bis zu einem Tausendstel Volt oder 0,001 im 3-V-Bereich sehen.

Die Auflösung in den technischen Daten eines Messgeräts wird unter Umständen als maximale Auflösung angegeben. Das ist der kleinste Wert, der im niedrigsten Messbereich erfasst werden kann.

Eine maximale Auflösung von 100 mV (0,1 V) bedeutet zum Beispiel, dass bei Einstellung des Multimeterbereichs auf die Messung der höchstmöglichen Spannung die Spannung mit einer kleinsten Abstufung von 0,1 V angezeigt wird.

Die Auflösung erhöht sich durch Verringern der Bereichseinstellung des Digitalmultimeters. Dabei ist aber darauf zu achten, dass der Messwert noch innerhalb des eingestellten Messbereichs liegt.

Welche Messbereiche hat ein Multimeter?

Messbereiche und Auflösungen eines Digitalmultimeters sind voneinander abhängig und werden in den technischen Daten eines Digitalmultimeters angegeben.

Viele Multimeter verfügen über eine Funktion zur automatischen Bereichswahl, die automatisch den richtigen Bereich für die auszuführende Messung auswählt. Das ermöglicht sowohl ein aufschlussreiches Messergebnis als auch die beste Auflösung für die Messung.

Wenn der Messwert außerhalb des Messbereichs liegt, zeigt das Multimeter „OL“ an (Overload, Überlastung). Die genauesten Messergebnisse werden mit der niedrigstmöglichen Bereichseinstellung erzielt, man muss aber darauf achten, dass das Multimeter bei manueller Bereichseinstellung nicht überlastet wird.

| Messbereich und Auflösung | |

| Messbereich | Auflösung |

| 300,0 mV | 0,1 mV (0,0001 V) |

| 3,000 V | 1 mV (0,001 V) |

| 30,00 V | 10 mV (0,01 V) |

| 300,0 V | 100 mV (0,1 V) |

| 1.000 V | 1.000 mV (1 V) |

Was ist der Unterschied zwischen Anzeigeumfang und Stellen?

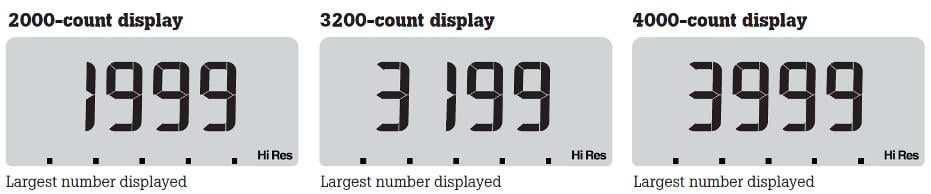

Anzeigeumfang und Stellen sind Begriffe, die zur Beschreibung der Auflösung eines Digitalmultimeters verwendet werden. Heute ist es üblicher, Digitalmultimeter nach dem Anzeigeumfang zu klassifizieren als nach der Anzahl der Stellen.

Anzeigeumfang: Die Auflösung eines Digitalmultimeters kann durch den Anzeigeumfang angegeben werden. Ein höherer Anzeigeumfang sorgt für eine bessere Auflösung bei bestimmten Messungen. Ein Multimeter mit einem Anzeigeumfang von 1.999 kann beispielsweise nicht bis zu einem Zehntel Volt messen, wenn 200 V oder mehr gemessen werden. Fluke bietet 3½-stellige Digitalmultimeter mit einem Anzeigeumfang von bis zu 6.000 (d. h. max. 5.999 auf der Anzeige des Messgeräts) sowie 4½-stellige Multimeter mit einem Anzeigeumfang von 20.000 oder 50.000 an.

Anzahl der angezeigten Stellen (Digits): Die Produktreihe von Fluke umfasst 4½- und 3½-stellige Digitalmultimeter. Ein 3½-stelliges Digitalmultimeter kann beispielsweise drei volle Stellen und eine halbe Stelle anzeigen. Die Angabe als Anzeigeumfang 1.999 ist allerdings eindeutiger. Die drei vollen Stellen zeigen Zahlenwerte zwischen 0 und 9 an. Die halbe Stelle, die die erste Stelle bezeichnet, zeigt bei einem Anzeigeumfang von 1.999 eine 1 an oder bleibt leer. Ein 4½-stelliges Digitalmultimeter kann viereinhalb Stellen anzeigen, was bedeutet, dass es eine höhere Auflösung als ein 3½-stelliges Gerät hat.